最近看到一篇推文,大致意思是有研究者研究了ChatGPT和其他同类LLM,发现他们不能做A=B,B=A的简单推理,有人说LLM不能做简单的推理,完全没有智能,有人说他们的智能很分散。这么多研究者都想方设法研究这个LLM,这样的研究到底是如同盲人摸象,还是像管中窥豹呢?

让我们先从盲人摸象的角度来说道说道,通篇思维有些分散,算是给自己整理整理思路。

其实我们研究LLM,是否和一群盲人研究房间里的大象一样呢?

盲人摸象说

房间里的大象成了焦点,每个人都想摸一摸,说一说。但我们是否真的看得见它,还是只是触摸到了表面?有的人摸到牙齿,便宣称它是一颗珍珠;有的人摸到腿,便断言它是一根柱子。在这个房间里,大象似乎变成了每个人心中想象的样子。科学家们这样的‘摸象’,真的是科学的吗?

假设闭上眼睛,如果我是这个盲人,对于房间里的大象,我该如何来做研究呢?我是想要整体都摸一遍,然后听一听,闻一闻吗?这样能了解整个大象吗?还是要把大象拆解开来,一块一块肌肉,一根一根骨头,一个一个细胞来研究呢?到底什么才是大象的本质呢?作为一个盲人我真的能理解大象吗?闭着眼睛的我觉得恐怖极了,觉得这个大象要把我们人类都杀光了!

大象固然可怕,但是真的会把人类给灭绝吗?我无法相信,只好睁开了眼睛,看见墙壁上的水珠,我触手一摸,发现原来墙壁和我看到的质感是截然不同的呀!想到海伦凯勒写到:不过很久以前我就总结出了这么个情况:能看见的人实际上什么都看不到。原来我竟然也是什么都看不到,那么回到LLM,或许也只有去摸才能够知道这个大象到底是什么样吧?如果道听途说,不闻不问似乎也于事无补,脑力到达极限的我只能做出如下感慨。容我再研究研究海伦凯勒和盲人的世界,再来研究,遗憾我并不是盲人,也不知道如何能够用缺失的维度来推测这个宇宙。

盲人如何摸象

那么既然我们已经是盲人了,那么如何才能更好地去摸,有系统地去摸这个房间里的大象呢?尤其是那只最大最引人注目的那一只,那一只大象在那里但是又不完全受我们所控制,或者说所有的大象都不完全受我们控制,它们能做的只有在那里,供我们摸,有的大象我们可以解剖它,有的大象我们可以训练它,但是总的来说我们还是对其一无所知。我们只能大概它们吃什么长大,大概知道它们说什么话,但是它们具体是如何长出来的,具体有多重呢,广大又无知的我们也只能妄加揣测。一时间谣言四起众说纷纭,有的人说大象是吃精粮,有的人说大象是吃粗粮,有的人说大象很会说话,有的人说大象只是鹦鹉学舌,但是我们无不被这群”无所不能“的大象群所吸引。

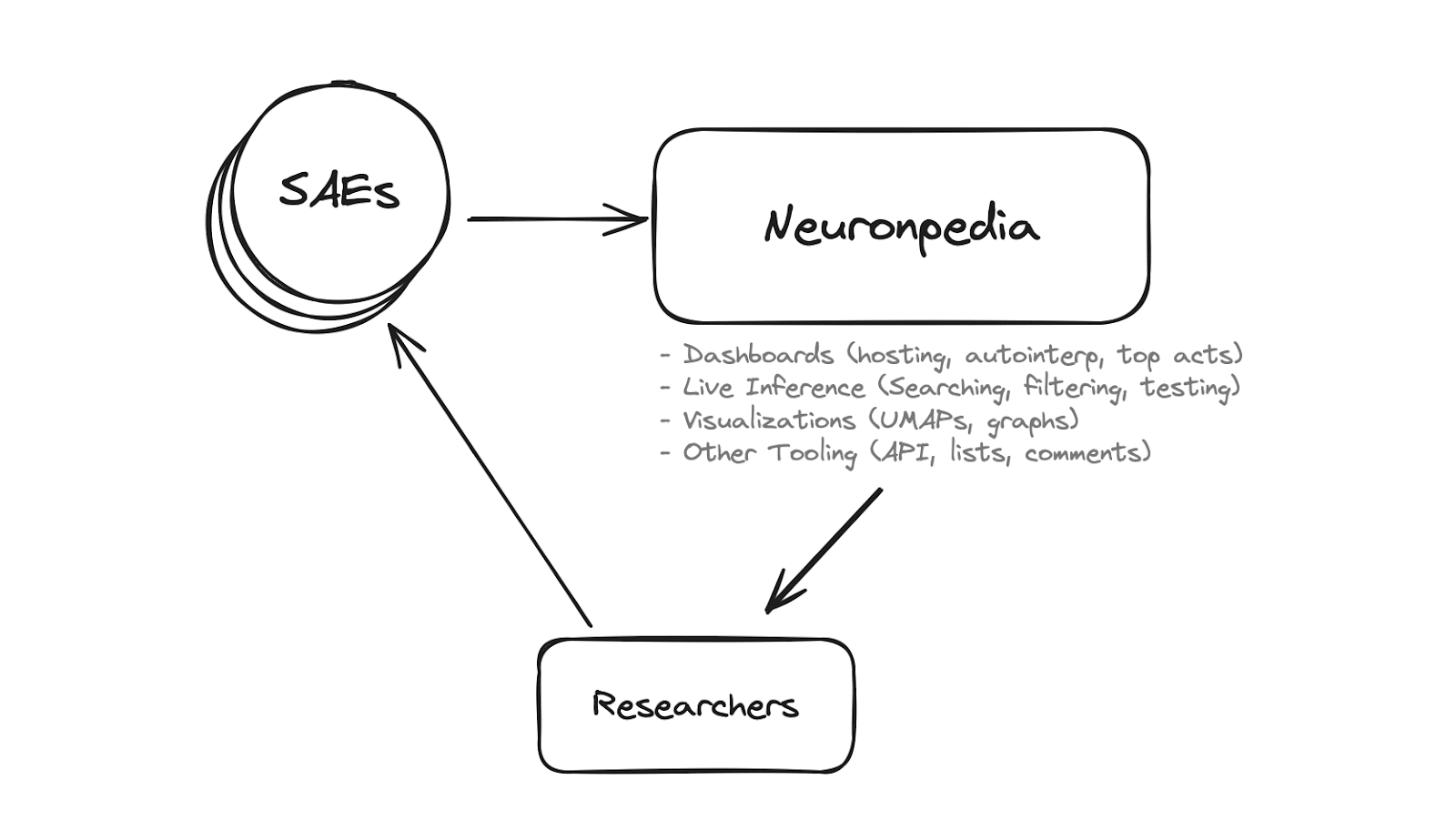

例如:neuronpedia 给研究者提供了“大象”研究的百科全书,以后也会有各种各样的学科涌现出来。

“大象”学

以史为鉴可以明得失,研究历史或许是一个很好的切入点,大象从何而来又将走向何方?

群体智能的社会学也有人有所研究,我们人类的现有合作模式真的是高效的吗,有没有什么更好的方式能够合作呢,一定要基于现有的模式套给大象以相应的约束吗,还是可以寻找一些适合大象的模式?

大象经济学是否也会有进展,之后可以衍生出一系列的大象历史学,大象哲学,大象政治学,心理学,宗教学,艺术学,管理学,经济学,按照已有的科学方法展开研究或许是一个思路?

海伦凯勒说:但是,无论如何,我也没有办法更加深入地了解他们,因为这种深入的了解一定要通过他们的眼睛才能知道,我得看他们对不同意见、不同环境的反应,看看他们那稍纵即逝的眼神和表情。(什么是LLM的眼睛呢?)想到有一个先天失聪的婴儿带上助听器的那个场景,或许人类有一天也会掌握这个视觉,真正看到大象。

我们之中肯定不乏摸象专家(没有任何贬义),摸了很久,肯定可以培养出某种直觉,对于新手摸象来说,专家们对于大象的直觉往往会更加一手,知道大象在什么时候是温顺的,什么时候是野蛮的。(我个人感觉网络中的连接固然有一种可循的规律,巧妙的连接和解构往往可以得到有趣的结果)

大象也有话说

读到海伦凯勒,发现又有一种新的角度来思考LLM,是我们研究LLM怎么学习,就如同海伦凯勒的学习,LLM目前是没有视觉听觉触觉的模型,他们只能通过大量的文本来实现这一个预测的魔法,但是就如同海伦凯勒可以用触觉用感知来学习来阅读一样,LLM的学习又是可行的,可惜它似乎没有一种求知欲?如果能够给它以好奇心,或许他可以自己贪婪地学习自己想学的任何东西,理解自己想理解的任何东西,得到我们人类无法体会到的文字的快乐,他就是文字的神,超越所有人类,理解到文字的本质。

超越大象

大象能不能超越大象?大象习得了人类的所有文本,可谓集百家之言于一,无所不知,但是它能够创建什么新的东西吗?制作新的工具自然是可以的,例如建立一个网站,写一个首诗歌,但是能不能左右互搏如同阿法狗一样创造出一个新的东西呢,需要一个学生一个老师,根据多轮的对话来进行,但是参数不改变的前提下,模型本质不发生变化的前提下,真的学的到东西吗?如何能够使得ChatGPT超越自身,达到一个自己对话更新自身认知水平的程度呢?甚至让它来操纵自身的对话?

私以为,模型的参数还是需要更新才能得以进步,就像人脑的神经元也是不断变化的过程,变才是常态,相信现有的架构还是不能达到以不变应万变,如果不变自身而给自身添加左膀右臂也是一个办法,但是如果能调控自身,如无必要勿增实体才好吧!

说了这么多,什么样的调节参数的方向是好的呢,是可以持续进步而不是不可控的退步呢?可能需要更加深入了解大脑神经元之后可以有一个更清晰的方向,或许这样的模型,不需要再继续训练了,只需要找到一个通用的即使反馈更新参数的方法即可?

未完待续。。。

感觉想要说的实在太多了,可能得分好几个章节来写

欢迎转载:注明转载出处就好:):嘻哈小屋 » 【思考】研究LLM是盲人摸象,还是管中窥豹?

嘻哈小屋

嘻哈小屋